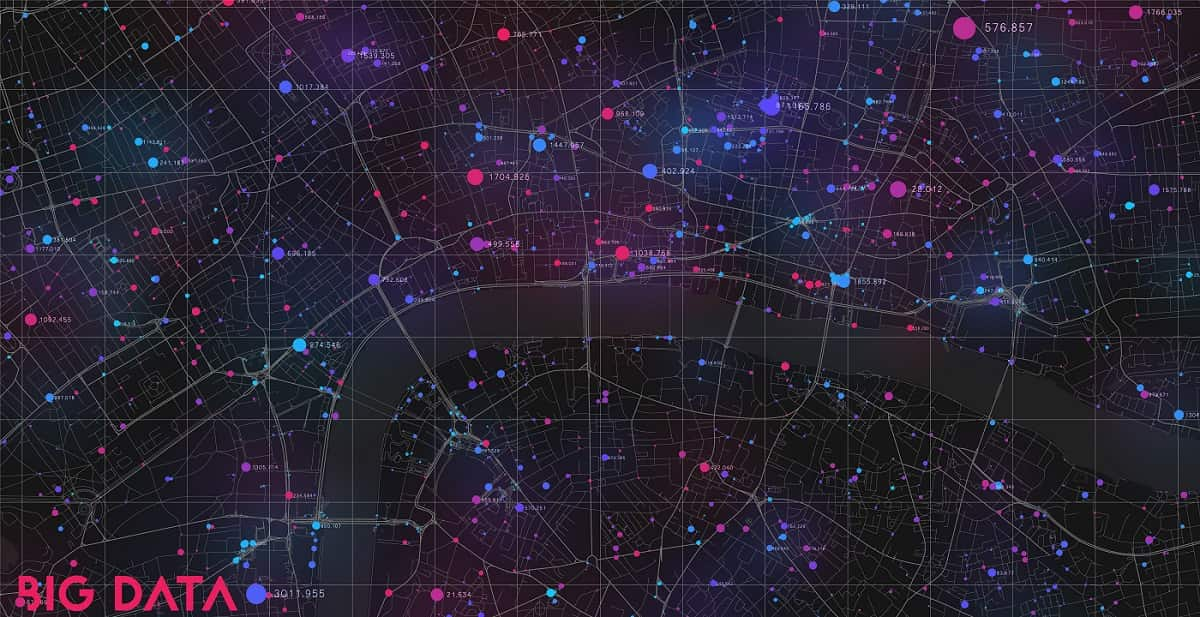

¿Sabías que tu próxima acción ya ha sido adivinada? ¿Sabías que tus gustos han sido descubiertos? ¿Eres consciente de que Facebook te conoce mejor que tu madre? Todo esto, que parece el argumento de una película de ciencia-ficción, tiene una clara explicación: el Big Data. En esta entrada explicaremos qué es y para qué sirve el Big Data.

¿Qué es el Big Data?

Se puede dar una definición del Big Data desde dos puntos de vista:

- Desde la perspectiva del tamaño de los datos, puede definirse como una gran cantidad de datos que no caben en una sola máquina, que se producen de una forma muy rápida y que, a veces, también es necesario interpretarlos y procesarlos en tiempo real.

- Desde un punto de vista puramente tecnológico, se define como un conjunto de procesos y tecnologías que permiten recoger y almacenar cantidades enormes de datos de distintas procedencias y tipologías, siendo la base tanto de la digitalización masiva del mundo analógico, como del almacenamiento de los propios datos generados en el mundo digital.

Por lo tanto, volviendo sobre la pregunta ¿qué es el Biga Data?, podemos decir que son conjuntos de datos de gran tamaño, complejidad y velocidad de crecimiento, que hacen difícil su captura, gestión y procesamiento a través de herramientas convencionales, como pueden ser las bases de datos relacionales.

Cuando hablamos de gran tamaño del volumen de datos manejados, si bien no hay un límite claramente definido, la mayoría expertos actualmente lo sitúa en torno a los 30-50 TB como mínimo y con un máximo que alcanza los varios petabytes.

La complejidad del Big Data proviene de la naturaleza no estructurada de los datos que generan las tecnologías modernas, como las redes sociales, los smartphones, los blogs, los sensores que incorporan los dispositivos actuales, los sistemas de identificación por radiofrecuencia, los GPS, etc. Esto, junto al gran volumen de datos, hace necesario el empleo de herramientas de Big Data tanto para la recolección de datos como para su posterior análisis.

Origen e historia

Esta entrada no sería una introducción al Big Data adecuada, si antes no hablamos de los orígenes de esta tecnología.

El término Big Data se utiliza desde finales de los 90 para definir a los sistemas de almacenamiento de grandes volúmenes de datos. Sin embargo, para encontrar el origen del Big Data hay que irse varias décadas más atrás.

En concreto, a la época de la 2ª Guerra Mundial, cuando Alan Turing, el padre de la computación, lideró un equipo cuyo objetivo era descifrar el código que empleaba el sistema Enigma utilizado por el ejército alemán. Este equipo trabajó con una enorme cantidad de datos para poder cumplir su objetivo, por lo que a Alan Turing se le considera pionero de lo que hoy se conoce como Big Data.

A mediados de los años 50 se produce otro gran avance en el campo del almacenamiento de datos, cuando Fritz Rudolf Guntsch crea la memoria virtual, capaz de procesar datos sin limitación por el hardware.

El Big Data siempre ha estado en cierta medida relacionado con la inteligencia artificial y el machine learning. En el año 1962, William C. Dersch crea la máquina ‘Shoebox’. Consistía en un sistema capaz de comprender el lenguaje humano, lo que hoy se llamaría language processing. En concreto, era capaz de entender 16 palabras y 10 dígitos.

La década de los 70 supone un gran avance en el desarrollo de las computadoras, lo que permite crear sistemas de bases de datos cada vez más grandes, lo cual permite a las empresas automatizar su gestión de inventarios.

Sin embargo, la primera vez que se menciona el término Big Data es en año 1989. En concreto, fue Erik Larsson quien mencionó el Big Data y el business intelligence como dos conceptos que van de la mano, puesto que el primero es una tecnología clave para el desarrollo del segundo.

Con el nacimiento de Internet en 1989 se inicia el camino hacia la creación de los primeros sistemas de gestión de información en 1992. Desde entonces hasta el día de hoy la importancia del Big Data no ha hecho más que creer y se ha convertido en un concepto clave para todo tipo de empresas e instituciones.

Las cinco Vs del Big Data

Los expertos en Big Data consideran que esta tecnología se caracteriza a través de cinco Vs:

Volumen

Como ya hemos mencionado, no hay una determinada cantidad de datos a partir de la cual se consideren datos masivos. Sin embargo, podemos considerar que el volumen de datos que maneja esta técnica sería de muchos Terabytes.

Imagina, por ejemplo, los datos de actividad de una empresa. Una mediana empresa puede utilizar un volumen de los datos que puede alcanzar cientos de Gigabytes. Esa información no se considera Big Data. De hecho, una empresa que guarde ese volumen de datos no utiliza la tecnología Big Data.

Sí se usa, en cambio, por empresas muy grandes. Por ejemplo, de comercio electrónico o por entidades financieras que generan enormes cantidades de datos.

Velocidad

Los datos usados en Big Data se trabajan a mayor velocidad que los gestionados en bases de datos tradicionales.

De esta forma, la inteligencia de datos se ocupa de datos que se generan en tiempo real, o incluso a velocidad superior de un dato por segundo.

Un ejemplo de ello son las transacciones que se realizan en la Bolsa de Nueva York en un día, donde las operaciones se ejecutan en menos de un nanosegundo.

Igualmente, Internet ha pasado a ser sin duda en el mayor motor de generación de contenidos. Y, por ello, en el gran generador de datos a gran velocidad.

En un minuto se envían más de 2.000 millones de e-mails, se realizan más de cuatro millones de búsquedas en Google o se suben una media de 300 horas de vídeo a YouTube.

Variedad

Si en alguna ocasión has trabajado con una base de datos sabrás que, en su mayoría, los datos que contiene son texto y números, a menudo relacionados entre sí en una base de datos relacional.

En el caso del Big Data los datos son más variados, no se trabaja solo con textos y números.

Los macrodatos trabajan con fotografías, vídeos, audio, series de datos temporales, y muchos otros tipos de datos. Y hay que tener en cuenta que a menudo estos datos son no estructurados como puede ocurrir, por ejemplo, con el contenido que se genera en un blog o en Twitter.

Veracidad

Se trata de la integridad de los datos.

Estos datos serán más veraces siempre y cuando el programa que los registre no esté comprometido. Partiendo de este supuesto, podemos confirmar que a mayor información, más fácil será que esta pueda ser constatada como información auténtica.

Sin embargo, debido a la infoxicación que se vive hoy en día y a la dificultad existente de contrastar las fuentes y de mejorar dicha información, es conveniente andar con cuidado para no ser manipulados con noticias falsas o fake news que puedan contaminar nuestras bases de datos.

Valor

El valor de los datos a gran escala está unido a la ventaja que podamos obtener de los datos, además del propio valor que los datos poseen.

Sin embargo, el verdadero valor del Big Data se encuentra en la conversión de los datos a información práctica a través de la analítica o del Big Data analytics.

Así, si se usa adecuadamente esta tecnología, las empresas podrían:

- Optimizar procesos

- Conocer mejor a sus clientes

- Ofrecerles publicidad asociada a sus gustos.

En definitiva, mejorar la competitividad.

Aquí podemos comprender claramente por qué se considera a los datos como el petróleo del siglo XXI.

El Big Data sería el equivalente a la extracción de la materia prima mientras que la analítica (esto es, la aplicación de algoritmos sobre los datos) supondría la acción de refinar esos datos a fin de darles un valor añadido en el mercado, siendo muchas veces el paso previo para la creación de una inteligencia artificial.

Tipos de Big Data

Cuando hablamos de Big Data y los datos asociados a esta técnica, podemos clasificarlos en dos tipos: según su procedencia y según su estructura.

En función de la procedencia de los datos tenemos, entre otras, las siguientes fuentes:

- Páginas web y blogs, todos aquellos datos que los usuarios generan al navegar por la Red.

- Redes sociales.

- Transacciones.

- Datos generados por la interacción entre sensores inteligentes en máquinas, también llamada comunicación machine-to-machine.

- Datos generados por la tecnología de reconocimiento biométrico.

- Datos generados por personas y organizaciones públicas y privadas a través de emails, mensajes, grabaciones de llamadas, estadísticas, historiales, etc.

En función de su estructura, los datos pueden ser:

- Estructurados, datos con formato, tamaño y longitud definidas.

- Semiestructurados, son datos con una estructura flexible, como los que se usan en XML y HTML o JSON.

- No estructurados, aquellos datos que no tienen un formato específico, como los textos o los contenidos multimedia.

Elementos de la tecnología Big Data

Junto con los datos, la tecnología Big Data necesita tres elementos fundamentales para garantizar que dispondrá de la capacidad suficiente para proporcionar los servicios.

Sistema de almacenamiento

Se trata de la infraestructura, física y lógica, necesaria para almacenar de forma eficiente las grandes cantidades de datos que se usan como fuente para el Big Data.

No solo la cantidad es importante, también lo es la velocidad de estos sistemas. De nuevo, no nos sirven las estructuras de los medios tradicionales de almacenamiento.

Empezando por el hardware, se desarrollaron nuevas formas de estructura para conseguir el almacenamiento usando muchos servidores con poca capacidad individualmente. Pero con enorme capacidad de forma conjunta.

El software tradicional tampoco era válido para los fines del Big Data. Por eso se crearon nuevos gestores de datos como puede ser Hadoop.

Sistema de procesamiento

Es necesario extraer información inteligente a partir del Big Data.

Por eso, además de ser capaces de almacenar los datos, debemos poder realizar cálculos y operaciones matemáticas partiendo de los mismos.

Sistema de comunicación

Este sistema es esencial para el funcionamiento efectivo y el rendimiento de los otros dos anteriores.

Y es que, tanto para poder almacenar datos, como para poder acceder a ellos, resulta necesario una infraestructura de red.

¿Para qué sirve el Big Data?

Una de las claves del Big Data es el uso de la analítica y la estadística.

Gracias a su uso se puede interpretar una enorme cantidad de datos, obtener información y aprovecharla para que sea utilizada en nuestro favor.

La analítica trata de ahondar en los datos para así encontrarles un sentido e interpretarlos.

A partir de la visualización de datos y su análisis podemos comprender cuestiones que eran desconocidas, como:

- Conocer la situación de un determinado elemento (por ejemplo, las ventas de una compañía) y las razones por las que sucede.

- Predecir el futuro más cercano a partir de los datos, para prepararnos y anticipar decisiones.

Todo ello ha originado el aumento de nuevos profesionales que ahora se necesitan para interpretar los datos, como el Big Data Analyst o el Big Data Architect, así como para adoptar decisiones estratégicas con respecto a los mismos, como el Chief Data Officer.

Las aplicaciones de la analítica en una empresa se dan en multitud de áreas. Puede aplicarse prácticamente a todos los departamentos de una compañía, con independencia de su sector o rama de actividad.

Por ejemplo, se pueden aplicar a las ventas, marketing, experiencia de clientes, riesgo financiero, y muchas más.

¿Por qué es tan importante el Big Data?

La importancia del Big Data reside en las ventajas y beneficios que aporta tanto a empresas como a particulares. En la era de la digitalización, la globalización y la conectividad, las viejas estructuras se rompen para dar paso a nuevas formas de abordar al consumidor y así poder presentarle una oferta que le aporte más valor.

Para particulares

Aunque normalmente pensamos que el Big Data es algo que solo sirve a las empresas, lo cierto es que los particulares también pueden beneficiarse de las aplicaciones que tiene esta tecnología.

Pensemos por ejemplo en los datos recogidos por nuestros dispositivos wearables como un reloj inteligente que mide tus constantes vitales, entre otras cosas. También es gracias al Big Data, que a partir de datos de salud conseguidos por medio de medidores puede conseguir el diagnóstico precoz de enfermedades.

Para empresas

Respecto al Big Data para las empresas, muchas ya supieron ver las ventajas que esta y otras tecnologías, como la minaría de datos, les podría aportar hace años.

Y así Axciom, Google, IBM o Facebook llevan años invirtiendo en descubrir nuevos usos de los datos, cómo tratarlos y cómo transformarlos en valor.

Este nuevo conocimiento, junto a las ventajas del Big Data, permite a las empresas crear nuevos servicios y productos más adaptados a las necesidades de las personas, lo que les permite tener una gran ventaja competitiva.

De entre todas, podemos decir que en el área de experiencia del cliente la analítica está jugando un papel más importante.

Así, en la actualidad y gracias al Big Data podemos conocer a cada cliente de manera individual, entendiendo más allá de una compra aislada y haciendo proyecciones al futuro. Además de descubrir patrones de comportamiento de los clientes.

Con el avance del Big Data nos encontramos con la creación de la publicidad conductual o publicidad dirigida, que es una forma de predecir, mediante el comportamiento de los usuarios, qué servicio o producto podría interesarte comprar.

Con esto las empresas pueden llegar a un público más interesado en sus anuncios, lo que significa vender más.

También se benefician:

- Administraciones Públicas

- Sector sanitario

- Sector financiero y bancario

El uso de los macrodatos supone:

- Tomar decisiones de forma más rápida y eficaz

- Realizar análisis predictivos

- Mejora continua de los sistemas de trabajo

- Mejorar la eficiencia.

Desafíos del Big Data

En la actualidad el Big Data se enfrenta a diferentes desafíos para convertirse en una herramienta todavía más poderosa.

Variedad de fuentes

El Big Data ha de ser capaz de gestionar datos provenientes de diferentes fuentes. Por ejemplo, de cualquier rincón de Internet, de teléfonos móviles, del Internet de las cosas, de datos recopilados por empresas especializadas u otros datos experimentales.

Como ya vimos en uno de los puntos anteriores, los datos que se manejan en Big Data provienen de muy diversas fuentes.

Distintos tipos de datos

También hemos visto que los tipos de datos se dividen en datos estructurados, semiestructurados y no estructurados, lo que obliga a crear sistemas capaces de manejarlos, analizarlos y gestionarlos de forma simultánea

Gran volumen de datos

Cada vez se recopila mayor cantidad de datos de todo tipo, lo que hace más difícil las labores de almacenamiento, mantenimiento y gestión de la información. Se hace necesario el desarrollo de sistemas capaces de procesar los datos en el menor tiempo posible y con el mayor grado de fiabilidad. Además, para que estos sistemas puedan funcionar de forma correcta es imprescindible que los datos sean de alta calidad.

Información volátil

Muchos de los datos que se recopilan son de naturaleza volátil y pueden variar rápidamente. Por ello, se necesitan sistemas de procesamiento capaces de adaptarse a esos cambios. De lo contrario, los datos serían erróneos y llevarían a análisis incorrectos o conclusiones equivocadas.

Estandarización precaria

Existen estándares de calidad de datos unificados, pero estos son de desarrollo muy reciente. En concreto, la norma ISO 8000 de calidad de datos fue desarrollada en el año 2011 y todavía debe perfeccionarse mucho.

La complejidad del Big Data

Dada la complejidad de los datos no estructurados y el gran volumen de datos en general que se maneja en el Big Data, se hace necesario contar con herramientas de Big data capaces de analizar, visualizar y gestionar estos datos para poder sacarles todo el partido y aprovechar las ventajas y beneficios que pueden aportar a las empresas.

Algunas herramientas de Big Data más usadas son:

- Las bases de datos NoSQL permiten trabajar con datos no estructurados, además son fácilmente escalables, lo que facilita el trabajo con grandes volúmenes de datyos. MongoDB o Apache Cassandra son dos ejemplos de este tipo de bases de datos.

- Hadoop (que ya hemos citado en esta entrada) es una herramienta de código abierto con la que se pueden gestionar grandes cantidades de datos, analizarlos y procesarlos.

- Lenguajes de programación que funcionan especialmente bien con Big Data, como R o Python.

- La biblioteca de JavaScript D3.js permite producir visualizaciones dinámicas e interactivas de datos en navegadores web mediante HTML, SVG y CSS.

- Elasticsearch permite procesar grandes cantidades de datos y ver su evolución en tiempo real. También proporciona gráficos para presentar la información.

- Apache Storm es una herramienta de código abierto que puede usar con cualquier tipo de lenguaje de programación y es capaz de procesar en tiempo real grandes cantidades datos, creando topologías para transformarlos y analizarlos.

Plan de Gobernabilidad en Big Data

A la hora de crear un plan de Data Government en la empresa es necesario cumplir ciertos requisitos. A continuación vemos los pilares en los que se debe asentar la gobernabilidad de los datos.

Autorización y control de acceso

Los datos deben estar protegidos por mecanismos que peritan decidir quién puede acceder a qué datos. Se han de establecer diferentes niveles de protección y permisos de autorización. El enmascaramiento de datos será progresivo desde los datos más confidenciales a los que pueden estar disponibles para toda la empresa o para el público en general.

Seguridad perimetral

Los datos han de viajar seguros y deben seguir estando seguros al final de la cadena. Por tanto, hay que crear un perímetro de seguridad alrededor de la información que la proteja. Los cortafuegos o los estándares de autenticación integrados con los datos son fundamentales. Es decir, no se trata de tener una infraestructura se seguridad y autenticación separada, sino integrada en la estructura existente.

Encriptación de la información

Una vez que se ha superado el perímetro de seguridad y se tiene permiso de acceso a los datos, se debe poder garantizar la seguridad de los archivos y la información personalmente identificable. Para ello se deben usar los mecanismos de encriptación, anonimización y tokenización adecuados que permiten realizar las tareas o análisis sin que esos datos identificativos queden expuestos.

Realización de auditorías

Hacer auditorías es fundamental para saber si el acceso a los datos se produce en las condiciones de seguridad adecuadas. También puede tener otros objetivos, como evaluar la calidad de los datos y si la información es óptima para un correcto procesamiento de los datos.

Arquitectura global unificada

Un plan de Data Governance debe apoyarse en el acceso granular, la seguridad, el cifrado de la información y la elaboración de auditorías. Pero todo ello no funcionaría si todos estos componentes no formaran parte de una misma estructura y se enfocaran en una misma dirección. Es decir, se trata de crear una arquitectura global de datos sea se segura, escalable y funcione de forma unificada.

Ejemplos de Big Data

Ahora que ya hemos explicado qué es y para qué sirve el Big Data, vemos dos ejemplos de Big Data.

Amazon

El primero de nuestros ejemplos de aplicación de Big Data lo tenemos en Amazon; si sois usuarios de este enorme comercio electrónico, sin duda os habréis dado cuenta de que muchos de los productos que os aparecen al entrar en su web están relacionados con búsquedas y compras hechas anteriormente en ella. Esto es especialmente notable cuando accedemos a la sección «Mi Amazon», en la que directamente se nos ofrecen productos recomendados para nosotros y que seguramente suscitan nuestro interés.

Estas recomendaciones de productos, el mostrarnos aquellos artículos que más nos pueden interesar lo logra Amazon gracias al empleo del Big Data. A través de esta técnica, Amazon recoge información de sus usuarios, concretamente aquella relacionada con los historiales de búsqueda, la lista de deseos, las compras realizadas y el tiempo pasado en páginas, comentarios y el seguimiento de productos.

Con el Big Data en Amazon, la compañía es capaz de ofrecer una experiencia personalizada para cada usuario, gracias a una gran segmentación de los mismos. También es capaz de predecir comportamientos de consumo e impulsar el interés de nuevos productos de los usuarios.

Pongámoslo así; si al entrar en un e-commerce ves diversos productos que te pueden o no interesar, es posible que navegues en busca de algo concreto y acabes comprándolo. Pero si al entrar, te aparecen productos en los que ya has mostrado interés alguna vez (por ejemplo, novelas policíacas), es más probable que eches un vistazo a las sugerencias antes de ir a aquello que estás buscando e incluso realices alguna compra.

Además, Amazon no solo se beneficia del Big Data para mejorar sus ventas, también es una de las características que ofrece su base de datos AWS.

El segundo ejemplo de aplicación de Big Data lo tenemos en Google y lo cierto es que nos daría para escribir otra entrada (o más) ver cómo Google emplea esta técnica, puesto que está presente en muchas de sus funciones y aplicaciones. Sin ir más lejos, que los anuncios que aparecen en las webs cuando navegamos por Internet sean de productos o servicios en los que hemos mostrado algún tipo de interés en el pasado, se debe a Google y su recopilación de datos de los usuarios que utilizan Chrome como navegador principal.

Pero si miramos un poco más al futuro, podemos ver cómo el coche autónomo en el que trabaja Google emplea el análisis del Big Data para poder circular de forma segura. Estos coches recopilan datos de las cámaras y sensores que llevan incorporados y que se comunican entre sí, junto al GPS, la conexión a Internet y las unidades de procesamiento, la cantidad de datos que se genera es enorme y poder analizarla en tiempo real es esencial.

Conclusión

Tras este extenso repaso, como conclusión del Big Data sacamos que no es una tecnología y una técnica del futuro, sino que ya está aquí y ha venido para quedarse, puesto que hay diferentes empresas que ya se han comenzado a beneficiar del análisis de la información que aportan estas grandes cantidades de datos. Sin embargo, también es cierto que aún le queda camino por andar para alcanzar un mayor potencial, algo de lo que seremos testigos ahora que llegan el 5G y el Internet de las cosas.

El Big Data y todo lo asociado a esta técnica y las tecnologías que lo hacen posible son, además, una oportunidad de futuro, puesto que se prevé la creación de miles de puestos de trabajo relacionados con ello. No olvidemos que se estima que para 2025 habrá 20.000 millones de dispositivos conectados intercambiando información en Internet y será el Big Data el encargado de analizar los datos que surjan de esas comunicaciones y transformarlos en información útil para empresas y particulares.

Escribe aquí tu comentario